MainBrainstorm

www.mainbrainstorm.com

info@mainbrainstorm.com

Ticino - Svizzera

MainBrainstorm

www.mainbrainstorm.com

info@mainbrainstorm.com

Ticino - Svizzera

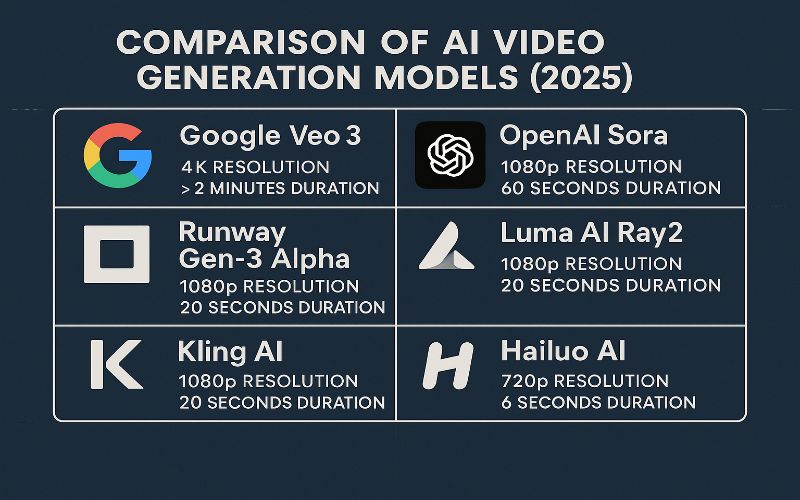

Negli ultimi anni, i modelli di intelligenza artificiale per la generazione di video hanno raggiunto livelli di realismo e versatilità avanzati. Questo articolo analizza e confronta le caratteristiche tecniche dei principali modelli video AI 2025, mettendo a confronto realismo, controllo e audio., tra cui Google Veo 3, OpenAI Sora, Runway Gen-3 Alpha, Luma AI Ray2, Kling AI, Hailuo AI e il precedente ModelScope AI. L’analisi si concentra su aspetti come qualità visiva, controllo cinematografico, durata del video, supporto audio e prestazioni fisiche, fornendo esempi ipotetici per illustrare le capacità di ciascun modello.

(tempo di lettura 11 minuti)

Veo 3, sviluppato da Google DeepMind, è l’ultima evoluzione della famiglia Veo, ipotizzato per generare video ad alta fedeltà fino a una risoluzione di 4K. Integra audio generato nativamente, inclusi dialoghi, effetti sonori e rumori ambientali. Secondo Google (2025), utilizza un’architettura basata su modelli di diffusione avanzati, addestrati su vasti dataset, probabilmente includendo contenuti video di YouTube. Offre controlli cinematografici precisi, come la selezione di angolazioni, movimenti della telecamera e tipi di lente. Tra i modelli video AI 2025, Veo 3 è tra quelli con il miglior equilibrio tra qualità visiva e controllo cinematografico.

Sora, parte dell’ecosistema ChatGPT, si distingue per la semplicità d’uso e l’ipotetica integrazione con strumenti di editing come Remix, Loop e Blend. Supporta una risoluzione massima di 1080p (con 4K in sviluppo, secondo OpenAI, 2025) e si concentra sulla coerenza narrativa e visiva, anche se può presentare limitazioni nella simulazione fisica complessa. La sua architettura combina modelli di diffusione con un framework Transformer multimodale, elaborando input testuali, visivi e video per generare clip fino a 60 secondi (Axios, 2025). Sora è uno dei modelli video AI 2025 più user-friendly, pensato per creator e storyteller digitali.

Gen-3 Alpha di Runway è progettato per i creatori che cercano flessibilità e rapidità. Disponibile dal 2024, supporta video fino a 1080p con una durata massima di 20 secondi (AI4Business, 2024). La sua forza risiede nell’interfaccia intuitiva e nelle funzionalità di editing integrate, utilizzate in produzioni come Everything Everywhere All At Once (AI4Business, 2024), che permettono di modificare clip direttamente sulla piattaforma. Tuttavia, la simulazione fisica è meno avanzata rispetto a Veo 3, con occasionali anomalie visive in scene dinamiche.

Ray2 di Luma AI si concentra sulla produzione di video realistici per applicazioni creative e professionali, con una risoluzione fino a 1080p e una durata di fino a 20 secondi (nugg.ad, 2025). Utilizza un approccio di diffusione ottimizzato per la coerenza visiva, ma manca di supporto audio nativo, richiedendo integrazioni esterne per colonne sonore o dialoghi. È particolarmente apprezzato per la sua velocità di elaborazione (Geopop, 2025).

Questi modelli cinesi, sviluppati rispettivamente da Kuaishou e MiniMax, si distinguono per il realismo visivo. Kling AI supporta video fino a 1080p con una durata massima di 20–30 secondi (nugg.ad, 2025), mentre Hailuo AI è limitato a clip di 6 secondi a 720p (Corriere.it, 2025). Entrambi eccellono nella resa di dettagli visivi, come texture e movimenti facciali, ma mancano di controlli cinematografici avanzati e supporto audio integrato.

ModelScope AI, popolare nel 2023, è ormai superato rispetto ai modelli più recenti. Con una risoluzione limitata a 720p e evidenti errori visivi, come nella celebre clip di “Will Smith che mangia spaghetti” (Il Post, 2025), rappresenta un punto di riferimento storico per valutare i progressi del settore. La sua architettura, basata su reti generative avversarie (GAN), non regge il confronto con i moderni modelli di diffusione (Il Post, 2025).

Questo confronto mostra le principali differenze tecniche tra i modelli video AI 2025, evidenziando i punti di forza di ciascuno.

| Modello | Risoluzione Massima | Durata Massima | Supporto Audio | Controlli Cinematografici | Simulazione Fisica |

|---|---|---|---|---|---|

| Google Veo 3 | 4K | >2 minuti (Google, 2025) | SÌ (dialoghi, effetti, Google, 2025) | Avanzati (Google, 2025) | Eccellente |

| OpenAI Sora | 1080p (4K in sviluppo, OpenAI, 2025) | 60 secondi (Axios, 2025) | NO | Moderati (storyboard) | Media |

| Runway Gen-3 Alpha | 1080p | 20 secondi (AI4Business, 2024) | NO | Moderati (editing integrato) | Media |

| Luma AI Ray2 | 1080p | fino a 20 secondi (nugg.ad, 2025) | NO | Limitati | Buona |

| Kling AI | 1080p | 20–30 secondi (nugg.ad, 2025) | NO | Limitati | Buona |

| Hailuo AI | 720p | 6 secondi (Corriere.it, 2025) | NO | Limitati | Buona |

| ModelScope AI | 720p | 10 secondi (Il Post, 2025) | NO | Nessuno | Scarsa |

Nei modelli video AI 2025, la durata massima e la coerenza narrativa sono elementi chiave per video professionali.

Solo alcuni modelli video AI 2025 permettono un controllo avanzato delle inquadrature e degli effetti visivi.

Prompt: “Un’inquadratura ravvicinata di un piatto di pancake con sciroppo d’acero che cola in slow motion, illuminato da una luce calda, in un’atmosfera accogliente, secondo un esempio ipotetico (Agenda Digitale, 2025).”

Prompt: “Un gatto di origami che cammina su una strada di carta in stile diorama, con pieghe nette e illuminazione drammatica, secondo un esempio ipotetico (Agenda Digitale, 2025).”

Prompt: “Un bicchiere d’acqua che si riempie lentamente, con riflessi di luce e bolle che salgono in superficie, secondo un esempio ipotetico (Agenda Digitale, 2025).”

Tra i modelli video AI 2025, Google Veo 3 si distingue come il più avanzato, grazie alla sua risoluzione 4K, supporto audio nativo e controlli cinematografici precisi, rendendolo ideale per produzioni di alto livello (Google, 2025). OpenAI Sora è una scelta eccellente per chi cerca semplicità e versatilità, particolarmente per contenuti brevi e narrativi (Axios, 2025). Runway Gen-3 Alpha, Luma AI Ray2, Kling AI e Hailuo AI si rivolgono a creatori che necessitano di soluzioni rapide e accessibili, ma mancano della profondità di Veo 3 (nugg.ad, 2025; Corriere.it, 2025). ModelScope AI, pur essendo un pioniere, è ormai obsoleto (Il Post, 2025).

Per scegliere il modello giusto, è fondamentale valutare le esigenze specifiche: Veo 3 per progetti professionali con budget elevati, Sora per contenuti social rapidi, e gli altri per applicazioni di nicchia o budget limitati. Test approfonditi con prompt specifici possono aiutare a identificare il modello più adatto al proprio flusso di lavoro creativo.

Google Veo 3 è attualmente il più avanzato, con risoluzione 4K, supporto audio nativo e controlli cinematografici dettagliati, ideale per progetti ad alto budget.

Sora è pensato proprio per i creator: semplice da usare, integrato con strumenti creativi e capace di generare video coerenti e narrativi in pochi minuti.

Offrono ottima qualità visiva, ma mancano di supporto audio e controlli cinematografici evoluti. Sono utili per clip veloci, ma non per produzioni complesse.

Fondamentale: modelli come Veo 3 gestiscono fluido, luce e gravità con realismo, mentre altri (es. ModelScope) falliscono anche su compiti base, creando artefatti.

Runway Gen-3 Alpha o Ray2 sono ideali per rapidità e facilità d’uso. Offrono qualità accettabile per clip brevi e sono perfetti per contenuti su Instagram, TikTok e YouTube Shorts.